解决scrapy爬虫报错 pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection

scrapy爬虫报错内容pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }, full error: {‘index’: 0,

scrapy爬虫报错内容

pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }, full error: {‘index’: 0, ‘code’: 11000, ‘keyPattern’: {’_id’: 1}, ’

keyValue’: {’_id’: ObjectId(‘61989dfcfe585e2673d7ee1b’)}, ‘errmsg’: “E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }”}

2个步骤解决:

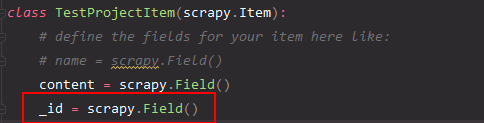

1.爬虫items.py加入_id字段

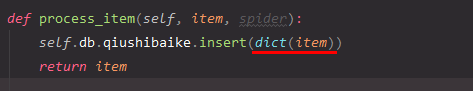

2.我们使用 MongoDB 只能插入字典,但是item 是类似字典所以报错。

插入数据的时候做一个字典的转化动作:

注:我的scrapy版本是2.5.1

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)